Künstliche Intelligenz in der Medizin mit Federated Learning und Explainable AI

Studien legen nahe, dass computergestützte Diagnostik mit Deep Learning-Ansätzen genauso gute Ergebnisse in der Erkennung von Krankheiten liefern kann wie Ärzte. Doch noch fehlt die flächendeckende Akzeptanz – vor allem aufgrund von Datenschutzbedenken und der Blackbox-Problematik. Mit seiner Masterthesis will Sebastian Dahnert aus unserem Data Science-Team dazu beitragen, die Bedenken auszuräumen und den KI-Einsatz in der Diagnostik von Lungenkrankheiten voranzutreiben.

Die computergestützte Diagnostik mittels Deep Learning stellt eine vielversprechende Möglichkeit dar, Diagnoseprozesse effizienter und unabhängiger vom individuellen Fachwissen sowie von der zeitlichen Verfügbarkeit eines Spezialisten zu machen. Ein Anwendungsfall ist die Diagnose von Lungenerkrankungen in Röntgenbildern. Studien haben gezeigt, dass Neuronale Netze mindestens genauso gut in der Erkennung von Krankheiten sein können, wie Radiologen. Trotz der bemerkenswerten Ergebnisse fehlen die breite Akzeptanz und damit auch der flächendeckende Einsatz von Deep Learning in Kliniken.

Besonders die Blackbox-Problematik der Algorithmen erschüttert das Vertrauen in Deep Learning: Es ist nicht ohne weiteres möglich, das erlernte Wissen des Neuronalen Netzes und die darauf basierenden Diagnosen für den Menschen verständlich und somit nachvollziehbar zu machen. Darüber hinaus benötigen die meisten KI-Algorithmen eine Fülle an Daten. Für das Training eines Neuronalen Netzes, müssen Krankenhäuser oder Radiologen entweder selbst über eine ausreichend große Datenmenge verfügen oder sich mit anderen Krankenhäusern zusammenschließen. Letzteres wirft jedoch Datenschutzbedenken auf. Nicht zuletzt deshalb stehen die Themen Datenschutz und Explainable AI in wissenschaftlichen und regulatorischen Institutionen weit oben auf der Agenda. Datenschutz, Interpretierbarkeit und Robustheit werden in den EU-Richtlinien ausdrücklich als Schlüssel-Anforderung für KI erwähnt. Diese Anforderungen können in zukünftigen Regulierungen münden.

Datenschutzbedenken mit Federated Learning ausräumen

Eine Lösung zur Erhöhung des Datenschutzes ist das Federated Learning. Es ermöglicht Teilnehmern (in diesem Fall Krankenhäuser oder Radiologien), ein gemeinsames Modell kooperativ zu trainieren, während alle Trainingsdaten lokal bei ihnen verbleiben. Zum Start erhalten alle Teilnehmenden von einer zentralen Instanz ein un- oder vortrainiertes Neuronales Netz, das sogenannte globale Netz. Anschließend wird dieses globale Netz von jedem lokal mit den eigenen Daten trainiert. Dadurch entsteht jeweils ein trainiertes lokales Netz. Danach werden lediglich die Parameter (Gewichte) der lokalen Netze an einen zentralen Server übertragen, auf dem sie zu einem verbesserten globalen Modell zusammengeführt werden.

Meist geschieht dieser Prozess iterativ, bis das globale Modell die angestrebte Trefferquote in der Detektion erreicht. Das verbesserte globale Modell wird anschließend wieder an alle Teilnehmer ausgeliefert, die somit indirekt vom Beitrag und den Daten der anderen profitieren. Das Hauptziel von Federated Learning ist es, ohne eine zentrale Speicherung der Patientendaten alle Teilnehmer von einer breiteren und diverseren Datenmenge profitieren zu lassen – auch kleine Krankenhäuser oder spezialisierte Radiologen, die selber nur eine kleine Datenmenge beisteuern können.

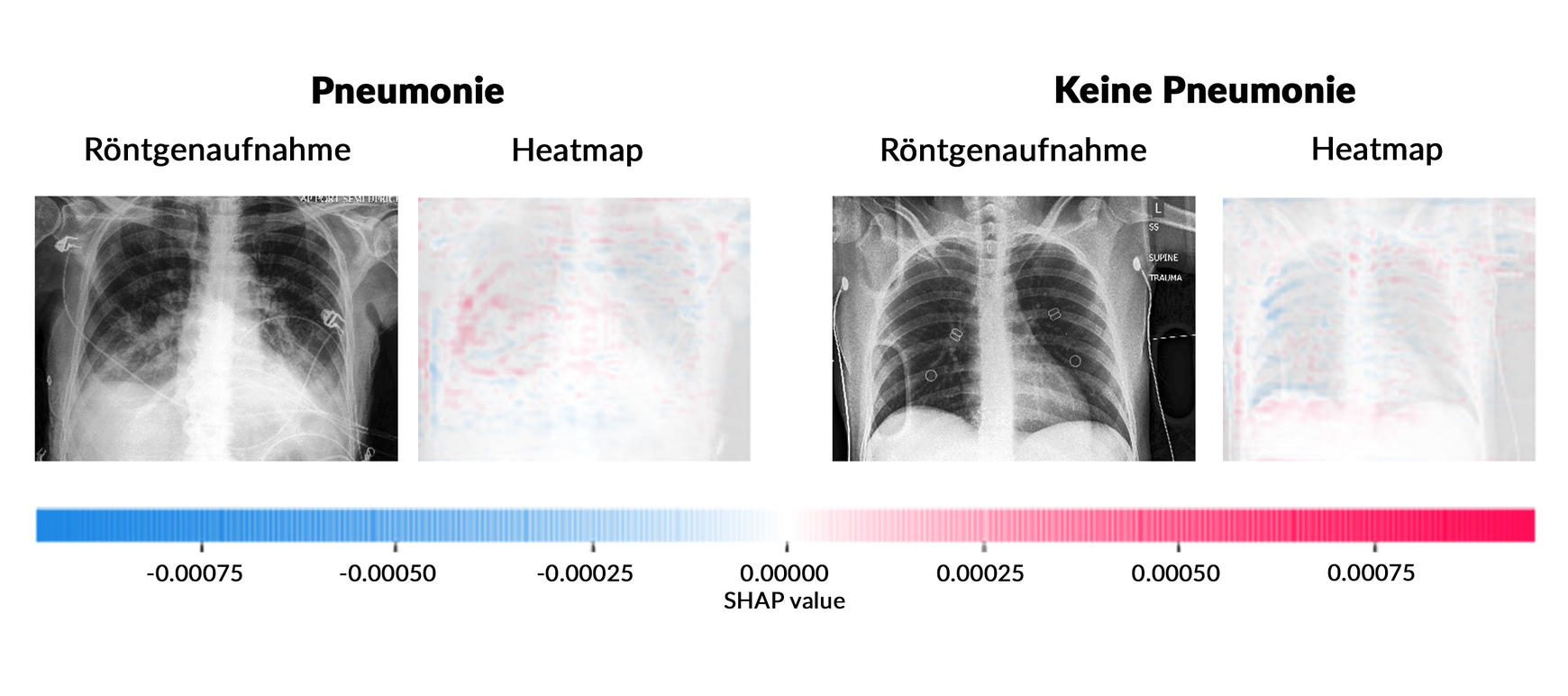

Explainable AI zur Auflösung der Blackbox

Ein Ansatz zur Lösung der Black-Box-Problematik stellt Explainable AI (XAI) dar. XAI zielt unter anderem darauf ab, dem Nutzer verständlich zu machen, warum der Algorithmus eine bestimmte Schlussfolgerung gezogen hat. Bei der auf Deep Learning basierenden Bildklassifizierung wird mit XAI beispielsweise eine Heatmap erzeugt, in der die Pixel oder Bereiche farblich markiert werden, die maßgeblich für die jeweilige Klassifizierung verantwortlich sind. Die unten stehende Abbildung zeigt eine Heatmap, die mit dem SHAP-Wert erzeugt wurde. Im Beispiel "Pneumonia" (Lungenentzündung), zeigen die roten Pixel die Bereiche, die für diese Diagnose sprechen. Auf der anderen Seite zeigen die blauen Pixel im Beispiel "Keine Pneumonia", den Bereich, der gegen eine Lungenentzündung spricht. Die Lungenentzündung zeigt sich im Röntgenbild als helle, verdichtete Struktur, denn je dichter ein Gewebe ist, desto heller wird es dargestellt. Deshalb sind die Knochen im Röntgenbild besonders gut abzugrenzen. Dieser Zusammenhang lässt sich bereits in den ersten Ergebnissen der Thesis erkennen. Das Neuronale Netz konzentriert sich besonders auf die hellen Bereiche zwischen den Rippenknochen.

Die Integration von XAI in die medizinische Bildklassifizierung kann über Interaktives Maschinelles Lernen (IML) erfolgen. IML bindet den Menschen in den Modellierungs-, Trainings- und Korrekturprozess ein, um das Modell zu optimieren. Der sogenannte Human-in-the-Loop-Algorithmus ermöglicht menschlichen Experten wie Radiologen, die Qualität des Neuronalen Netzes durch Inspektion der Heatmaps während des Trainings zu überprüfen.

Vielversprechende erste Schritte

Die Kombination von Federated Learning und Explainable AI über einen Human-in-the-Loop- Ansatz scheint vielversprechend für die Klassifizierung medizinischer Bilder zu sein. Da die Integration innerhalb des genannten Anwendungsfalls noch nicht erprobt wurde, ist die praktische Umsetzung das primäre Ziel der Thesis. Dafür ist eine Auseinandersetzung mit den Trade-offs zwischen den beiden Technologien wichtig, da sich die drei konkurrierenden Dimensionen von Machine Learning-basierten Anwendungen auf Genauigkeit, Interpretierbarkeit und Datenschutz beziehen. Ein Abgleich mit dem Expertenwissen eines Radiologen ist geplant.